Depuis quelques mois, je génère plus de 40 articles par jour avec l’aide de l’IA pour alimenter une trentaine de sites web de niche. Oui, vous avez bien lu : quarante articles quotidiens, répartis sur plus de 30 sites différents. Dans cet article, je partage mon retour d’expérience à la première personne sur cette méthode de SEO programmatique. Je vous expliquerai mon stack d’outils (de Google Sheets à WordPress, en passant par Make et l’API d’OpenAI), l’architecture du workflow automatisé, la façon dont je découpe la génération de contenu en modules (« hachage »), comment je gère la mémoire de mes agents IA, comment j’intègre automatiquement les métadonnées SEO (méta titres, descriptions, alt images…), tout en protégeant les données sensibles. Nous verrons aussi les paramètres avancés (température, top penalty…) que j’ajuste pour obtenir des textes uniques et de qualité, et enfin les KPI que je suis de près pour mesurer la performance SEO et améliorer en continu mes prompts. Le ton se veut convivial mais technique – embarquez avec moi dans les coulisses de cette production de contenu à l’échelle ! 🚀

Pourquoi automatiser la production de contenu SEO ?

Avant d’entrer dans le vif du sujet, un peu de contexte. Gérer un réseau de sites de contenu nécessite une alimentation régulière en articles. Un site qui ne publie plus s’essouffle inévitablement côté SEO. Dans mon cas, l’objectif n’était pas tant de réduire les coûts de rédaction que de gagner du temps et augmenter le volume : nous avions besoin de sortir 40 à 50 articles par jour pour couvrir différents sujets sur nos sites. Impossible de suivre la cadence via des agences de rédaction classiques (ou alors en en coordonnant plusieurs ! 🤯). L’automatisation par l’IA s’est donc imposée comme solution pour scaler la production de contenu sans sacrifier la qualité.

Bien sûr, qui dit automatisation dit souvent peur d’une baisse de qualité. Peut-on réellement écrire des articles utiles, qui rankent bien, grâce à l’IA ? Mon expérience prouve que oui, c’est possible, à condition d’avoir la bonne méthodologie. Plutôt que de demander bêtement à ChatGPT de pondre un article et de passer ensuite des heures à le corriger, j’ai élaboré un workflow SEO automatisé où l’IA est orchestrée en plusieurs étapes contrôlées. Ce procédé me permet aujourd’hui de produire des centaines d’articles par mois sur mes sites, avec un contenu cohérent, informatif et optimisé SEO.

Mon stack d’outils pour un SEO programmatique automatisé

Pour mettre en place ce système, j’utilise quatre outils principaux qui communiquent ensemble sans code (ou presque) :

- Google Sheets : ma base de données centralisée pour les idées d’articles et les données associées (titres, mots-clés, informations chiffrées à inclure, liens, etc.).

- Make (Integromat) : la plate-forme d’automatisation qui sert de chef d’orchestre. Elle déclenche les différentes tâches (appels à l’IA, mise en forme, publication…).

- OpenAI (Playground / API) : le moteur d’IA générative qui produit les textes via des appels API à GPT (ou autre LLM). J’y configure un agent IA dédié à mes contenus.

- WordPress : le CMS où sont publiés les articles automatiquement en fin de processus (avec leurs métadonnées SEO).

Voici un tableau récapitulatif de ce stack d’outils :

| Outil / Plateforme | Rôle dans le workflow SEO automatisé |

|---|---|

| Google Sheets (ou Excel / Notion) | Base de données des contenus : chaque ligne = 1 article à générer. Contient le titre, mots-clés, brief, stats, liens, etc. |

| Make (Integromat) | Automatisation du workflow par modules. Vérifie les nouvelles lignes dans le sheet et enchaîne les actions (appel API IA, formatage, publication…). |

| Agent IA (OpenAI API) | Génération du texte via IA. L’agent (ChatGPT/GPT-4 via Playground API) reçoit des instructions précises à chaque étape pour rédiger une partie de l’article ou des métadonnées. |

| WordPress (ou autre CMS) | Publication du contenu final. Make se connecte à l’API WordPress pour créer l’article avec le texte généré, ainsi que remplir les champs SEO (titre, méta desc, alt images…). |

Ce stack est accessible aux non-développeurs : Make permet de créer des scénarios d’automatisation par une interface visuelle (type flowchart), et l’API d’OpenAI se maîtrise sans coder grâce au Playground. On pourrait remplacer Make par Zapier ou n8n, et WordPress par tout autre CMS qui offre une API (Webflow, Wix, Ghost, etc.). L’important est d’avoir ce trio [Base de données] – [Automatisation] – [CMS] autour de l’IA pour bâtir un système complet.

Architecture générale du workflow automatisé

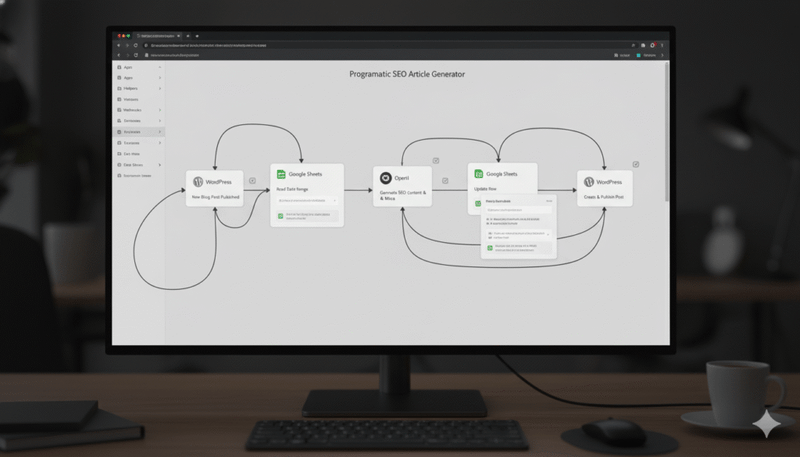

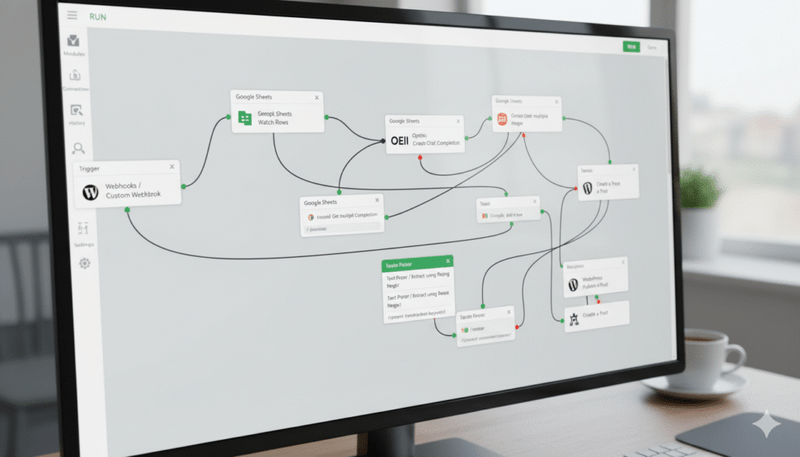

Passons à l’architecture du workflow SEO lui-même. Voici comment se déroule, étape par étape, la génération d’un article du réseau :

- Ajout d’une idée d’article dans le tableur – Je (ou mon équipe) renseigne une nouvelle ligne dans Google Sheets avec les informations de base : titre provisoire, mot-clé principal, brève description ou angle, données chiffrées importantes à inclure, éventuels liens internes/externes pertinents, etc. Ce sheet est en quelque sorte le backlog des contenus à produire, enrichi de tous les éléments factuels pour éviter un article creux. (Par exemple, pour un article sur la formation professionnelle, on pré-remplit une statistique du type « 90 % des apprenants constatent une augmentation de salaire » avec sa source, afin que l’IA l’intègre au texte.)

- Déclenchement du scénario Make – Make surveille le Google Sheet. Lorsqu’une nouvelle ligne apparaît (ou est marquée « À générer »), Make la détecte et démarre le workflow d’automatisation. C’est le point d’entrée du processus : « Nouvel article à créer → on y va ! »

- Appels successifs à l’agent IA (hachage) – Au lieu de demander directement un article complet à l’IA (ce qui donnerait un résultat médiocre), Make va découper la rédaction en plusieurs modules spécialisés. C’est ce que j’appelle le système de « hachage » (j’y reviens en détail dans la section suivante). En résumé, Make va appeler l’API OpenAI plusieurs fois de suite, avec à chaque fois une instruction précise et un contexte restreint, pour générer une partie de l’article à la fois.

- Premier module : l’agent IA rédige l’introduction de l’article. Pour cela, Make lui envoie le titre/mot-clé depuis la feuille, et éventuellement un aperçu de la concurrence (les titres des articles similaires déjà en ligne) afin de s’en inspirer tout en se démarquant.

- Module suivant : l’agent génère un tableau récapitulatif ou un sommaire juste après l’intro, pour donner tout de suite aux lecteurs les réponses clés. (C’est très apprécié des internautes pressés 😉 et bon pour le SEO, car cela structure le contenu.)

- Modules suivants : l’agent rédige tour à tour les différentes sections du corps de l’article (par exemple, les H2/H3 avec leur paragraphe), en intégrant à chaque fois les données spécifiques fournies dans le Google Sheet (statistiques, exemples, liens). Chaque section est traitée comme un sous-module séparé, avec son propre prompt.

- Module FAQ : j’inclus souvent une FAQ en fin d’article générée par l’IA, pour couvrir des questions connexes et enrichir le contenu (utile pour le SEO et possiblement pour apparaître en featured snippet).

- Dernier module : l’agent propose une conclusion ou une ouverture pour clôturer l’article de façon naturelle.

- Compilation du contenu et intégration des métadonnées – Une fois que tous les modules de texte brut sont revenus de l’IA, Make assemble le tout pour former l’article complet en HTML (en insérant les titres, les listes, les tableaux, etc., au bon format). C’est aussi à cette étape que l’on génère et ajoute automatiquement les métadonnées SEO : le méta-title de la page, la méta-description, les balises ALT pour les images, éventuellement les tags ou catégories… Pour ce faire, Make peut refaire appel à l’agent IA en mode « génère-moi un titre optimisé SEO de 60 caractères », « résume-moi l’article en 160 caractères pour la description », etc. (Nous détaillerons plus bas comment l’IA m’aide à remplir ces champs pour maximiser la visibilité, notamment à l’ère de la recherche générative.)

- Publication sur WordPress – Enfin, le workflow se termine par la publication sur le site. Grâce au module WordPress de Make (ou via une requête API), l’article formaté est automatiquement publié dans le CMS cible, avec son titre, son contenu HTML, les images éventuelles, et toutes les métadonnées SEO générées. 🎉 L’article est en ligne sans que j’aie eu à copier-coller quoi que ce soit manuellement.

Ce workflow automatisé tourne pour chaque nouvelle entrée du tableur. À terme, cela me permet de faire fonctionner un véritable pipeline de content marketing industrialisé. Je peux ajouter 2–3 idées d’articles par jour et les voir sortir le jour même sur chacun de mes sites, puis augmenter progressivement la cadence (après quelques semaines, certains sites publient 3–4 articles par jour sans encombre).

Important : j’ai choisi d’automatiser environ 90 % du processus, mais pas 100 %. Je garde une légère intervention humaine pour le contrôle qualité. Par exemple, je relis en diagonale certains articles publiés pour vérifier qu’il n’y a pas d’incohérences ou de « hallucinations » de l’IA, et j’ajuste mes prompts en conséquence (nous y reviendrons). J’ai aussi parfois des validations manuelles sur des sujets sensibles. Bref, l’IA fait le gros du boulot, mais je reste chef d’orchestre et garant de la cohérence éditoriale globale.

Le système de « hachage » : des agents IA ultra-spécialisés par tâche

Venons-en à cette notion de “hachage”, qui est au cœur de ma méthode. Derrière ce terme imagé, l’idée est simple : mieux vaut demander 10 fois une petite chose à l’IA que 1 fois une grosse chose. Autrement dit, il faut découper la génération de texte en sous-tâches ultra-spécialisées.

Pourquoi s’embêter à fractionner comme ça ? Parce qu’un prompt fourre-tout du style « Écris-moi un article de 800 mots sur tel sujet, avec introduction, plan, conclusion… » donne souvent un résultat fade et générique. L’IA essaie de tout faire en une passe, elle survole les points sans entrer dans le détail. On se retrouve avec un texte moyen qu’il faut retravailler longuement à la main. Frustrant et contre-productif.

En travaillant par itérations successives (hachage), j’obtiens au contraire un contenu beaucoup plus riche et précis. 💡 Concrètement, cela veut dire :

- Je focalise chaque prompt sur un objectif précis. Par exemple : « Rédige l’introduction en 2 paragraphes, en accrochant le lecteur et en définissant tel concept ». L’agent se concentre uniquement sur l’intro, il y excelle.

- Après chaque réponse de l’IA, je raffine avec une instruction supplémentaire. Par exemple : « OK, maintenant génère un tableau récapitulatif des questions clés et réponses courtes », puis « Développe la première section en détail… », etc. L’IA affine ainsi le contenu au fur et à mesure, au lieu de tout inventer d’un coup.

- Au total, je peux avoir 4, 5, parfois 8 appels API pour arriver au résultat final. Cela peut sembler beaucoup, mais c’est encore très rapide (quelques secondes chacun) et le texte final est 100× meilleur qu’avec un one-shot. L’IA étant comme un humain, si on lui donne 15 consignes en même temps, elle va s’emmêler les pinceaux ; alors que pas à pas, elle reste focus.

Cette approche modulaire suit un peu le principe du « divide and conquer ». Dans mon workflow Make, chaque appel API correspond à un module bien défini (intro, paragraphe X, FAQ, conclusion…). J’attribue même plusieurs agents IA différents si nécessaire, chacun expert de sa tâche. Par exemple, je pourrais avoir un agent spécialisé en « rédaction d’introduction percutante », un autre en « génération de FAQ SEO », etc., afin d’optimiser encore la qualité de chaque section. (C’est très aligné avec certaines études récentes qui montrent que les IA performantes sont celles qu’on entraîne sur des tâches ciblées plutôt que généralistes.)

En bref, le hachage me permet d’obtenir un article final bien meilleur, structuré, avec moins de répétitions et plus de profondeur. C’est ainsi que mes contenus échappent à l’écueil des articles IA basiques qui « grattent juste la surface de l’iceberg ». Ici, au contraire, chaque partie est travaillée en détail avec des données concrètes, des exemples… ce que Google valorise de plus en plus dans ses core updates.

Gérer la mémoire de l’IA : contexte, thread et données externes

Un défi lorsqu’on enchaîne plusieurs appels à l’IA, c’est de garder le contexte d’un appel à l’autre. Sur l’interface ChatGPT classique, c’est transparent : la conversation se souvient de tout ce qu’on s’est dit. Mais via l’API, par défaut chaque requête est indépendante : l’IA n’a pas « mémoire » de la réponse précédente si on ne la lui redonne pas.

Comment j’ai résolu ce problème ? Initialement, j’adoptais un hack tout simple : à chaque module, j’incluais en entrée le texte déjà produit précédemment (ou au moins un résumé de la réponse précédente). Par exemple, quand j’attaquais le module 2, je renvoyais en prompt l’intro générée au module 1 pour rafraîchir la mémoire de l’IA, et ainsi de suite. Ça marche, mais c’est très coûteux en tokens : plus l’article avance, plus on renvoie de texte à chaque requête, ce qui alourdit la facture (et peut finir par saturer la limite de tokens de la requête).

J’ai donc cherché mieux. La solution a été d’exploiter une fonctionnalité du Playground OpenAI : la notion de thread (fil de discussion) via l’API. Au lieu d’appeler l’endpoint basique, je crée dans OpenAI un agent IA dans le Playground, qui conserve le fil des échanges. Make peut alors appeler cet agent en précisant un thread ID (identifiant de conversation) : ainsi, toutes les réponses successives restent en mémoire côté IA ✅. Concrètement, c’est presque comme si j’avais mon ChatGPT personnel côté serveur : pas besoin de redonner tout l’historique à chaque fois, l’agent se souvient des dernières instructions et du texte déjà généré dans ce thread.

- Par exemple, après l’intro, mon appel pour le tableau récapitulatif peut simplement dire « Génère un tableau Questions/Réponses synthétique », sans rappeler tout le contenu de l’intro, puisque l’agent a conservé le contexte du thread.

Cela représente une énorme économie de tokens (donc de $$$) et facilite la mise en place du workflow. Techniquement, il suffit de passer le paramètre de conversation dans les appels API (plutôt que d’appeler l’API de manière stateless). Tout cela sans utiliser de solutions compliquées de « mémoire externe » tierce : c’est natif dans l’API d’OpenAI quand on l’utilise bien.

Bien sûr, j’ai quand même une mémoire externe côté workflow, qui est tout simplement… le Google Sheet 😁. Toutes les données structurées utiles à l’article y sont présentes, et Make les injecte au bon moment dans les prompts. On peut voir le sheet comme la connaissance de base que je donne à l’IA pour chaque article. Par exemple : je crée des colonnes « Faits marquants », « Statistiques », « Référence source », etc., et je les utilise dans les requêtes. Avant de générer un paragraphe, Make envoie à l’agent un prompt du style : « N’oublie pas d’inclure le fait suivant : 90% des apprenants… (source : Le Parisien). » L’IA intègre alors cette donnée dans sa réponse pour crédibiliser et enrichir le contenu.

Cette combinaison d’une mémoire interne (le thread qui garde le contexte du texte généré) et d’une mémoire externe (les données du tableur qu’on fournit au fur et à mesure) permet à mes agents IA d’être cohérents et précis tout au long de l’article. Ils ne se contredisent pas, ne répètent pas inutilement, et intègrent les chiffres et sources que je juge importants. C’est un point crucial pour obtenir des articles expert et éviter l’effet “générique” qu’on reproche souvent aux textes IA.

Métadonnées SEO : tout est généré automatiquement (ou presque)

En plus du corps de texte, un article optimisé SEO, c’est tout un ensemble de métadonnées qu’il faut penser à renseigner. Titre SEO (meta title), description, balises alt pour les images, éventuellement balisage de données structurées, etc. Bonne nouvelle : l’IA peut aussi nous aider là-dessus, et j’ai donc automatisé la génération de ces métadonnées.

Deux approches s’offrent à vous pour les métadonnées :

- Manuelle assistée : vous pouvez choisir de garder le contrôle et de les rédiger vous-même en vous basant sur votre base de données. Par exemple, remplir dans le Google Sheet une colonne “Meta Title” à la main pour chaque article, puis Make prendra cette valeur et la mettra dans WordPress. C’est envisageable si vous êtes très pointilleux… mais ça reste du travail manuel.

- Automatique par l’agent IA : c’est mon choix, afin de tout produire d’un coup. Je demande simplement à l’IA de générer ces champs après coup, à partir de l’article rédigé. Typiquement, une fois l’article complet assemblé, Make envoie au même agent IA une instruction du genre : « Donne-moi un méta-titre SEO accrocheur de 60 caractères max pour cet article », en lui fournissant le titre et un bref résumé. L’IA me renvoie un méta-title optimisé (généralement je lui fais inclure le mot-clé principal). Pareil pour la méta-description en ~160 caractères, ou encore pour le texte alternatif des images : « Voici l’intitulé de l’image, génère un texte ALT descriptif et incluant le mot-clé si possible. » En quelques secondes, j’ai des métadonnées prêtes à l’emploi.

Exemple réel : Sur un de mes sites WordPress, dès qu’un article est généré, Make appelle l’API OpenAI via un module pour remplir trois champs méta automatiquement : le meta title, la meta description, et le ALT text d’une image d’illustration. L’agent IA fait ça très bien à partir du contenu qu’il vient d’écrire. Ensuite, Make pousse ces valeurs dans WordPress via l’API REST (par exemple, pour Yoast SEO ou autre plugin de SEO utilisé sur le site).

Résultat : toutes les métadonnées SEO cruciales sont remplies sans que j’aie à lever le petit doigt, et ce pour chaque article. C’est un gain de temps énorme, et ça garantit une cohérence entre le contenu et ses meta. Google apprécie, et bonus, cela prépare aussi l’avenir de la recherche IA générative : on entend que les LLM (comme ceux de Bing ou Google SGE) scrollent de plus en plus les métadonnées des pages pour formuler leurs réponses. Donc autant les soigner systématiquement. J’ai même ajouté un module générant une FAQ structurée (balises <FAQPage>) en JSON-LD pour certains articles, toujours via l’IA, afin d’être éligible aux rich snippets.

Évidemment, il faut rester vigilant : un meta title ou une description générés automatiquement peuvent parfois être un peu trop génériques. Je fais des passes de relecture de temps à autre. Mais honnêtement, l’IA a tendance à proposer des metas plutôt bien ficelés (elle reprend souvent la phrase d’accroche de l’intro, ce qui est pertinent). Et si quelque chose ne me plaît pas, je le corrige ensuite à la main dans WordPress. On n’est pas obligés d’automatiser jusqu’au dernier détail ! Dans mon workflow, j’ai estimé que 90 % d’automatisation était le bon équilibre : tout ce qui est routinier et normé (rédaction structurée, champs meta, etc.) est fait par la machine, mais la porte reste ouverte à de l’intervention humaine pour ajuster une tournure, vérifier une info sensible, etc.

(D’ailleurs, sur les données sensibles/confidentielles : j’ai évidemment fait attention à ne jamais envoyer à l’API OpenAI des infos propriétaires ou critiques en clair. Si mon sheet contenait des données privées, je les anonymiserais ou je m’assurerais d’être sur un plan OpenAI qui n’utilise pas les données pour entraîner les modèles. Voire j’utiliserais un modèle open-source en local pour ces cas-là. C’est un point à ne pas négliger dans tout projet d’IA : protéger les données sensibles en choisissant les bons paramètres et infrastructures.)

Des textes uniques : réglages de température et top penalty

Produire du contenu à la chaîne, c’est bien, mais encore faut-il éviter de pondre 40 clones du même article… Pour cela, j’ai pu jouer sur les paramètres de génération de l’IA. Deux en particulier se sont révélés très utiles : la température et ce que j’appelle le « top penalty » (pénalité de répétition).

- Température : C’est le degré de créativité aléatoire de l’IA. Avec une température basse (proche de 0), l’agent est terre-à-terre et donnera toujours des réponses très similaires (ultra-factuelles, presque rigides). À l’inverse, avec une température élevée (vers 1 ou plus), il va être plus original, mais aussi prendre plus de libertés (risque d’hallucinations ou de ton inégal). J’ajuste donc ce curseur selon le contexte. Pour de la génération d’article SEO, je reste généralement autour de 0.5 de température, afin d’avoir un style naturel mais pas trop farfelu. Si je montais à 0.9 ou 1, je sens que l’IA pourrait partir dans des analogies ou exemples un peu tirés par les cheveux pour « être créative », ce qui n’est pas forcément souhaité ici. À 0–0.2, au contraire, elle serait trop plate. Mon conseil : testez différents niveaux de température pour trouver le bon équilibre entre facticité et variété du texte. Chaque niche de contenu peut avoir son sweet spot.

- Top P / Pénalités de répétition : Dans l’API OpenAI, il existe des paramètres pour pénaliser la réutilisation de certains tokens ou mots. Autrement dit, on peut forcer l’IA à ne pas trop répéter les mêmes termes ou tournures d’un article à l’autre. Je configure par exemple un “presence penalty” élevé sur le mot-clé principal une fois qu’il a été cité. Cela oblige l’IA à utiliser des synonymes et champs lexicaux plutôt que de matraquer le même terme 15 fois (ce qui, en plus d’être mauvais pour le style, peut sembler artificiel aux yeux de Google). Concrètement, si je mets une pénalité de 0.8 ou 0.9 sur un mot, l’IA aura tendance à ne l’utiliser qu’une ou deux fois maximum, puis à le reformuler autrement. Si je descends cette pénalité à 0.5 ou moins, je deviens encore plus strict : le terme pourrait n’apparaître qu’une seule fois. Cela m’aide à générer plusieurs articles sur des sujets proches sans qu’ils aient l’air copiés-collés. Chaque texte va utiliser des synonymes, des tournures variées, tout en parlant du même sujet. Pour le SEO, c’est idéal car on couvre un vocabulaire plus large (donc longue traîne) et on évite le contenu dupliqué.

En combinant ces réglages (température modérée + pénalité de répétition assez haute), mes articles bénéficient d’un ton cohérent mais sans être uniformément monotones. L’IA parvient à “réécrire” le même type de contenu de 40 façons différentes si besoin, ce qui est précieux quand on lance un site multi-pages sur une thématique donnée. On obtient du contenu qui reste unique et original aux yeux des moteurs.

À noter que j’ai aussi dans mes prompts encouragé l’IA à varier les structures de phrases et à utiliser des synonymes. Par exemple, je précise « n’utilise pas toujours les mêmes introductions de phrase » ou « emploie des variantes lexicales pour le mot formation : cours, entraînement, apprentissage… ». L’IA s’exécute bien et ça contribue à la naturalité du rendu.

Suivi des performances et amélioration continue des prompts

Avoir une usine à contenus automatisée, c’est génial, mais l’objectif final reste d’améliorer le SEO de mes sites (trafic, conversions, etc.). J’accorde donc beaucoup d’importance à la mesure des performances de ces articles et à l’optimisation continue du système grâce à ces données.

Les KPI SEO que je suis de près sont :

- Impressions dans Google Search Console : C’est l’indicateur numéro 1 que je regarde au démarrage. Si mes articles sont bien indexés et commencent à apparaître dans les résultats, le nombre d’impressions va monter en flèche. Une courbe d’impressions qui passe de 0 à 1000 en quelques semaines me prouve que “quelque chose” se passe : Google nous affiche, donc nos contenus ont une légitimité sur certains mots-clés. C’est bon signe 💪. À ce stade, peu m’importe que le CTR (taux de clic) soit encore bas ou que le trafic soit maigre : l’important est d’abord de prendre place dans les SERP.

- Positionnement / Clics (CTR) : Une fois les impressions au rendez-vous, j’analyse pourquoi les clics suivent ou non. Si j’ai beaucoup d’impressions mais un CTR faible, je m’interroge : Est-ce que mes titres SEO sont suffisamment accrocheurs ? Mes méta-descriptions donnent-elles envie de cliquer ? Ou est-ce parce que mes articles ciblent des requêtes trop larges et pas assez intentionnelles ? Par exemple, j’ai eu le cas où certains contenus générés étaient un peu trop généralistes, pas assez pointus pour la requête visée, d’où un CTR faible. J’ai alors ajusté mes prompts pour que l’IA rende les titres plus attractifs et explicites, et j’ai enrichi les articles avec plus de détails concrets pour mieux satisfaire l’intention de recherche.

- Trafic organique (visiteurs) : Évidemment, au final ce qui compte c’est d’attirer des visiteurs qualifiés. Je regarde donc l’évolution du nombre de visites SEO sur chacun de mes sites. Grâce à la production intensive, j’ai vu certains passer de quelques dizaines à plusieurs milliers de visiteurs mensuels en l’espace de 3 à 6 mois. Cela confirme que la méthode fonctionne. Pour autant, je reste attentif à la qualité de ce trafic.

- Comportement utilisateur : via Google Analytics, j’observe le temps passé sur la page, le taux de rebond, etc. Si je constate qu’en moyenne les lecteurs ne restent que 10 secondes, c’est mauvais signe – peut-être que le contenu est décevant ou mal structuré. Au contraire, un temps moyen de 2-3 minutes sur un article de blog indique qu’il retient l’attention, ce qui est bon pour le SEO (et pour mes objectifs marketing en général). Ces métriques comportementales me servent donc de feedback sur la qualité du contenu généré.

- Conversions / KPI business : enfin, sur certains sites, je suis aussi des KPI plus concrets (inscriptions, leads générés, clics d’affiliation, etc.). Un contenu SEO n’est pas qu’une question de trafic, il doit idéalement contribuer à un objectif business. C’est un peu hors sujet ici, mais disons que j’ai des dashboards qui me permettent de voir, par exemple, combien de leads tel groupe d’articles IA a généré. Si une série d’articles n’amène aucune conversion, je peux décider de revoir leur angle ou d’en produire d’autres plus pertinents.

L’essentiel, c’est que ces données m’aident à affiner en continu le processus. Je fais régulièrement des ajustements de mes prompts IA sur la base de ce que je constate :

- Amélioration des prompts : Par exemple, j’ai remarqué que l’agent avait tendance à conclure les articles un peu abruptement ou de manière redondante. J’ai donc modifié le prompt de conclusion pour qu’il inclue une ouverture (question finale, invitation à agir, etc.). J’ai aussi affiné les instructions pour que l’IA insère plus systématiquement les mots-clés secondaires identifiés, afin de mieux couvrir le sujet (et parfois, j’ai carrément ajouté une étape où l’IA génère une liste de synonymes à incorporer).

- Choix de sujets : Grâce aux retours GSC, je vois quelles thématiques ont le plus de potentiel. Je peux alors orienter le remplissage du Google Sheet en conséquence. L’automatisation donne une vélocité telle qu’il est facile de faire des tests à grande échelle : si je publie 40 articles sur 40 sous-sujets et que 5 cartonnent, je vais produire plus sur ces 5 axes gagnants, toujours à l’aide de l’IA, et laisser tomber les 35 autres.

- Taux d’automatisation : Comme évoqué, je garde un certain contrôle humain. Si je décèle des erreurs ou des outputs délicats (ex : un agent IA qui aurait “halluciné” une source), je corrige et surtout j’implémente des gardes-fous dans le prompt. Typiquement, j’ajoute « Si tu ne connais pas la réponse, ne l’invente pas » ou « Appuie-toi uniquement sur les données fournies ». Ces consignes limitent les dérapages.

- Surveillance des évolutions SEO/IA : Le SEO est un domaine mouvant (Google change ses algos sans cesse), et l’IA évolue vite aussi (nouveaux modèles, nouvelles possibilités). Je reste donc en veille. Si Google annonce valoriser tel type de contenu ou meta, j’adapte mon workflow pour en tenir compte (grâce à l’IA, il suffit souvent d’ajouter une étape de plus au scénario Make). De même, si OpenAI sort une nouvelle version plus performante de son modèle, je la testerai pour voir si mes articles gagnent en qualité, ou si je peux réduire le nombre d’itérations (peut-être qu’avec GPT-5, 3 modules suffiront là où GPT-4 en nécessite 6, qui sait ?).

En somme, ce projet de SEO automatisé par IA est un processus d’apprentissage continu. Les données de performance alimentent une boucle d’amélioration qui rend le système de plus en plus pertinent. C’est presque un agent autonome qui s’auto-optimiserait… à ceci près que c’est moi qui, en coulisses, recode les règles en fonction des résultats. Mais honnêtement, c’est un véritable plaisir de voir l’IA produire du contenu de qualité et de pouvoir se concentrer sur l’analyse stratégique des résultats et sur la génération d’idées, plutôt que sur l’exécution fastidieuse de l’écriture initiale.

Conclusion : l’IA + l’automatisation, un game-changer pour le content marketing

Pour conclure, mon aventure dans le SEO programmatique dopé à l’IA a complètement changé ma façon de voir la production de contenu. Là où avant il fallait des armées de rédacteurs pour espérer couvrir un sujet en profondeur sur des dizaines de sites, je peux maintenant, seul ou avec une mini-équipe, générer des contenus fiables, variés et optimisés à un rythme industriel.

Le secret réside dans la bonne orchestration : un workflow bien pensé, qui utilise l’IA de façon intelligente (modules spécialisés, mémoire conservée, données d’entrée de qualité) et qui s’intègre parfaitement aux outils de publication. Le tout, sans perdre de vue l’humain : c’est bien moi qui conçois les prompts, qui choisis les angles, et qui analyse les résultats. L’IA est un accélérateur et un assistant ultra-rapide, mais c’est ma vision éditoriale qui la guide.

J’espère que ce partage vous aura inspiré si vous êtes marketeur, entrepreneur ou SEO cherchant à scaler votre production de contenu. Commencez petit : automatisez un bout du processus, testez un article IA par-ci par-là, mesurez… Puis industrialisez graduellement. Les outils comme Make, Zapier, les API d’OpenAI et consorts sont de plus en plus accessibles, même sans compétences techniques poussées. Le SEO automatisé n’est plus de la science-fiction, c’est une réalité opérationnelle en 2025 ! Il faut bien sûr le faire avec méthode et éthique (on ne veut pas inonder le web de contenus poubelle : il faut apporter de la valeur, même avec l’IA). Mais entre de bonnes mains, c’est un formidable levier de croissance.

Allez, sur ce, je retourne peaufiner mes prompts… L’algorithme de Google n’a qu’à bien se tenir 😉. Et si ce sujet vous passionne, je vous invite à écouter le podcast d’où est tiré cet article pour encore plus de détails et d’anecdotes sur la méthode. Bonne automation à tous !

🎙️ Pour aller plus loin, écoutez l’épisode de podcast complet “Squeeze & Scale” avec Alexis Stephan & Anna ci-dessous :